DeepSeek技术创新主要是在它的基础模型V3

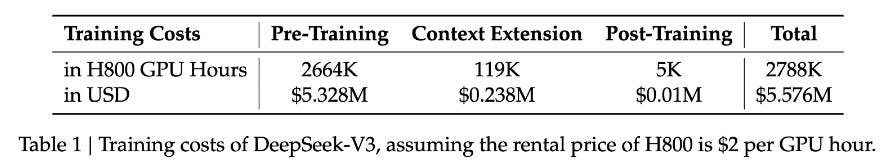

没有贬低李飞飞教授的论文价值,但的确是两个不同的东西。上图是V3最后一轮的训练得出稳定模型花费的算力。

DeepSeek 使用了14.8 trillion token(14,800,000,000,000)训练它的V3模型。仅考虑将这些token的文本,大概是14800 terabytes。如果将这些文本上传到AWS的S3存储,每月的存储费用是大概35万美元。将所有的数据上传至AWS要花费(假设每个文本文件5MB)大约1.5万美元。李飞飞教授论文中的数据是1千条数据。是从Google Gemini里拷贝下来的的。这儿是数据的链接:https://huggingface.co/datasets/simplescaling/s1K/viewer/default/train?row=0?

训练数据是6.88MB。6.88MB(6个0) VS 14800 TeraBytes(12个0)。从工程角度完全不是一个数量级。很惊诧文学城里许多人因为政治或其他原因不能理智客观的评价国内的开源模型。